Nye blanketkrav ved byretterne i sager om flykompensation

Baggrund

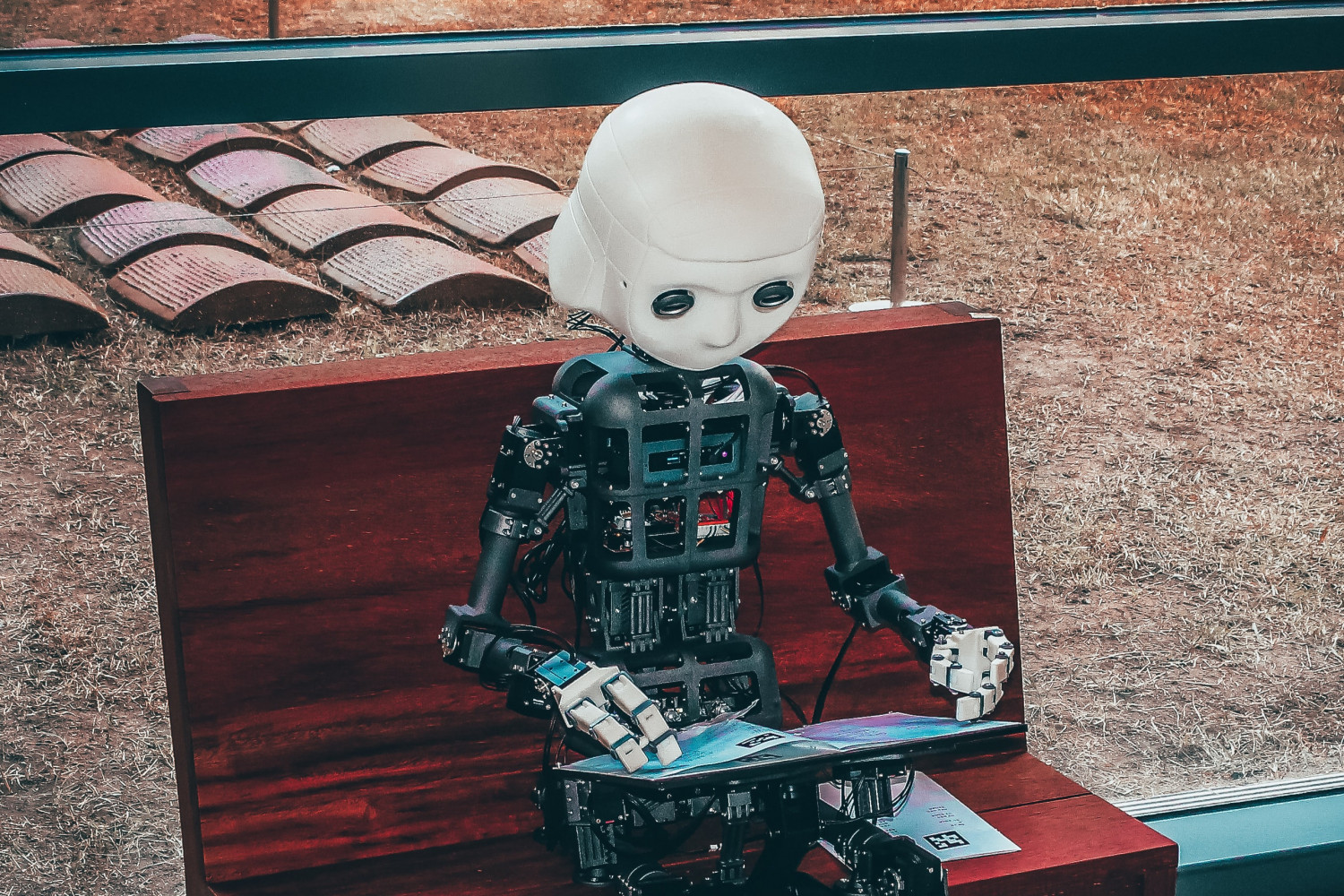

I april 2021 offentliggjorde Kommissionen et udkast til AI-forordningen, der stadig er under behandling i Bruxelles. Forordningen vil fastlægge grundlæggende lovgivning for AI-systemer og indeholder blandt andet forbud mod anvendelsen af visse former for kunstig intelligens og særlige krav til systemer, hvis anvendelse ventes at indebære en særlig risiko for krænkelse af individers rettigheder – såkaldte højrisikosystemer.

Forordningen indeholder ikke ansvarsregler og frygten for, at de nuværende nationale ansvarsregler ikke vil være effektive nok til at beskytte personer, der lider skade som følge af AI-systemer, har medført dette nye forslag, som skal ses som en af byggestenene i en sammenhængende AI- og dataregulering fra EU.

Produkter og services, der køres på, eller assisteres af kunstig intelligens, differentierer sig ved, at teknologien bag kan være kompleks og ugennemsigtig – særligt for den almene forbruger. Derudover består systemerne ofte af kombinationer af teknologi, der stammer fra en række forskellige producenter.

Dette kan gøre det svært for skadelidte at løfte bevisbyrden for, at en skade er påført af netop den kunstige intelligens i et produkt eller en service og dernæst præcist, hvilken del af systemet der er ansvarlig for skaden.

Hvad er nyt?

Direktivet indeholder to hovedpunkter, der begge udelukkende angår skade påført af højrisikosystemer. Sådanne systemer kan for eksempel være et CV-scannings program, der rangerer jobansøgere, eller et system der udregner kreditvurderinger og kan afskære låneansøgere fra at optage lån. Fejl i AI-systemer vil i praksis være eller blive "serielle" og derfor påvirke at stort antal personer.

Først og fremmest søger forslaget at lette bevisbyrden, når en fejl har ført til skade. Kompleksiteten i AI-systemer kan være vanskelig at gennemskue , og derfor foreslås en ”formodning om årsagssammenhæng” i tilfælde, hvor der konstateres en fejl, og det "forekommer sandsynligt", at AI-systemet har begået den. Dernæst vil Kommissionen give nationale domstole muligheden for at kræve, at både udbydere og brugere af højrisikosystemer gemmer og fremviser beviser for, hvordan systemerne fungerer.

Formålet bag direktivet er ikke blot at beskytte forbrugere, men ligeledes at tilskynde europæisk AI-innovation, ved at sikre klare regler for ansvar ved skade, samt en styrket tillid til teknologien bag.

Kritikken af forslaget vil dog være, at strengere regler kun hindrer væksten inden for området og står i vejen for de opstartsvirksomheder, der vil have EU-landene som deres væsentligste marked.

Bagsiden af reguleringen

Forslaget vil sandsynligvis ikke blive taget godt imod af erhvervslivet, da europæiske virksomhederne pålægges potentielt store byrder, hvis direktivet bliver gennemført i sin nuværende form på dette erstatningsretlige område, som historisk har udviklet sig fornuftigt i retspraksis uden behov for særregulering. Tilsvarende vil forbrugersiden argumentere for, at direktivets kriterier ikke er klare nok. Tiden vil vise, hvor meget skadelidte skal påvise, før at der i overensstemmelse med direktivet vil være tale om en ”rimelig sandsynlighed”. Samlet set er forslaget en forbedring af forbrugeres retsstilling på AI-udbydernes bekostning.

Der kan nå at komme mange ændringer til forslaget, før det endeligt vil træde i kraft, men udkastet har skabt fornyet europæisk debat om afvejningen af forbrugerbeskyttelse overfor erhvervslivet og innovationen.

Jurainfo.dk er landets største juridiske nyhedsside. Her finder du juridiske nyheder, kurser samt ledige juridiske stillinger. Vi hjælper dagligt danske virksomheder med at tilegne sig juridisk viden samt at sætte virksomheder i forbindelse med den rigtige juridiske rådgiver, når de har brug for råd og vejledning.